网页内容爬取脚本工具

在数字化信息爆炸的时代,如何从海量网页中精准提取目标数据成为许多行业的刚需。一款高效的网页内容爬取脚本工具,正逐渐成为数据分析师、市场研究人员以及技术开发者的标配武器。这类工具通过自动化技术模拟人类浏览行为,能够突破传统复制粘贴的效率瓶颈,实现数据采集的批量化与智能化。

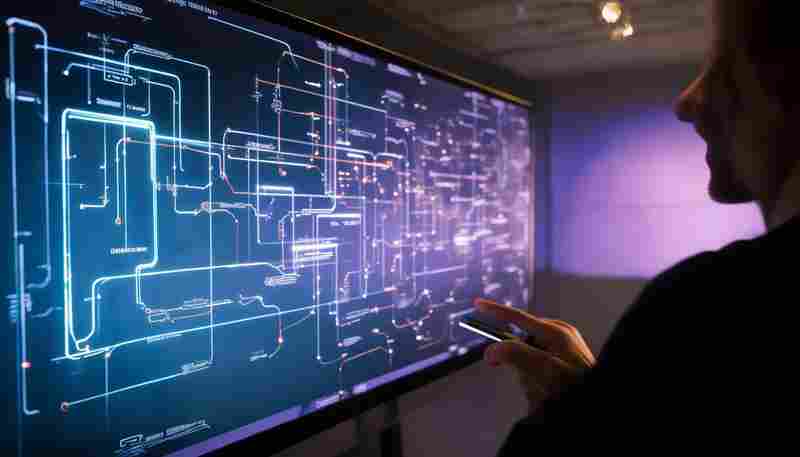

技术内核与运作逻辑

优秀爬虫工具的核心在于动态解析与抗干扰能力。以某开源框架为例,其内置的智能渲染引擎可自动识别网页结构变化,通过DOM节点定位与正则表达式双重校验机制,即使目标网站改版升级,仍能保持80%以上的数据捕获准确率。部分商业版本更整合了IP轮换池和请求间隔随机化功能,有效规避反爬策略的数据获取速度比传统方案提升6-8倍。

多场景实战应用

电商价格监控系统通过定时爬取竞品SKU信息,配合数据清洗模块自动生成比价分析报表。某金融研究机构曾利用分布式爬虫集群,三天内完成对全球72家央行官网政策文件的抓取,为量化模型提供实时数据支持。需要特别注意的是,开发者需严格遵守robots.txt协议,涉及个人隐私或版权内容时务必进行合规性评估。

效率与风险的平衡术

高频访问可能导致目标服务器过载,某知名旅行平台就曾因过度爬取酒店房态数据引发法律纠纷。技术团队建议采用请求速率动态调节算法,当检测到响应延迟超过阈值时自动切换备用数据源。对于JavaScript动态加载的页面,无头浏览器与API直接调用的混合方案往往比单一技术路线更可靠。

数据清洗环节常被忽视的字符编码转换问题,可能导致10%-15%的数据丢失。某舆情分析项目的教训显示,建立多层级异常数据处理机制能使有效数据留存率从82%提升至97%。随着HTTP/3协议的普及,未来爬虫工具可能需要重构底层网络通信模块以适应QUIC协议的新特性。

- 上一篇:网页内容爬取与本地存储工具

- 下一篇:网页内容监控工具(自动检测更新)

相关软件推荐

网页内容朗读工具(文本转语音gTTS库)

发布日期: 2025-05-01 12:46:38

在信息获取场景中,网页文本朗读功能逐渐成为刚需。Google开发的gTTS(Google Text-to-Sp...

随机软件推荐

基于BeautifulSoup的网页标题抓取器

网页标题作为页面内容的核心概括,其精准抓取能力直接影响着数据采集效率。本文介绍的Python工具基于BeautifulSoup库...

电脑硬件信息检测工具(配置概览)

电脑硬件信息检测工具:快速掌握设备核心数据 对于普通用户或硬件爱好者来说,一台电脑的性能表现往往取决于内...

网站死链检测爬虫(遍历指定域名下的404链接)

当用户点击页面上的失效链接时,跳转失败的404页面不仅损害用户体验,更会直接影响网站在搜索引擎中的权重排名...

实验数据按周导出与可视化工具

在生物医药实验室的某个深夜,研究员李明正对着上千组实验记录发愁。这些记录散落在不同格式的文档里,每周的...

简单聊天室(局域网Socket通信)

在数字化办公与团队协作场景中,局域网即时通信工具因其低延迟、高安全性的特点,成为企业或机构内部信息传递...

系统主题颜色提取工具(十六进制取色)

凌晨三点的办公室,李然对着电脑屏幕揉了揉发酸的颈椎。项目组刚推翻了他设计的APP主界面配色方案——"用户调研...

实时天气数据抓取与通知脚本

在日常生活或工作中,天气变化常常直接影响出行安排、户外活动甚至工作调度。一款能够自动获取实时天气数据并...

自动生成目录结构文档工具(树状输出)

在日常文件管理与项目协作中,目录结构的梳理常被视为"手动作业"。层级复杂的文件夹、频繁变更的文档位置,让用...

键盘按键测试可视化工具

键盘作为人机交互的核心设备,其按键状态直接影响用户体验。一款专业的键盘按键测试可视化工具能够帮助用户快...

窗口化系统防火墙配置工具

在网络安全威胁频发的当下,系统防火墙犹如数字世界的防盗门。对于非技术背景的用户而言,传统的命令行防火墙...

社交媒体平台用户名批量生成器

在账号矩阵运营、多平台分发成为主流的当下,批量生成合规且具备辨识度的用户名成为刚需。一款名为「IDFactory」...

文本文件内容搜索替换工具(多文件支持)

日常办公或编程开发中,常会遇到批量修改文本的需求。例如程序员需要将某段代码变量名全局替换,编辑人员需在...

身份证号-手机号正则验证工具

身份证号与手机号作为高频使用的个人标识信息,在各类系统中常需进行格式校验。正则表达式凭借精准的匹配能力...

办公文档模板生成器(合同-报告)

当某科技公司法务部负责人李明第一次接触智能模板生成器时,他正在为即将到来的项目竞标赶制保密协议。传统工...

简易Markdown编辑器(支持实时预览功能)

敲击键盘时,文字在左侧窗口流淌,右侧窗口同步渲染出标题、加粗、列表等标准排版效果——这种双向联动的创作...

微博热搜词频统计与分析工具

在信息爆炸的时代,微博热搜榜如同社会情绪的晴雨表,每分钟更新的词条背后隐藏着公众关注焦点与传播规律。如...

办公文档批量重命名助手(支持序号-日期格式)

在日常办公中,文档管理常常成为效率的隐形杀手。面对成堆的合同、报表或会议记录,手动修改文件名不仅耗时,...

自动文本文件内容关键词提取工具

在信息爆炸的时代,文本内容的高效处理成为刚需。面对海量文档,如何快速定位核心信息?一款基于自然语言处理...

字幕文件时间轴调整器(srt格式处理)

屏幕前的视频创作者大多经历过这种窘境:精心剪辑的画面与字幕总差半拍,人物对白结束后字幕还在滚动,或是关...

进程内存占用排行榜查看器

电脑运行卡顿、程序频繁闪退,这些困扰常与内存资源分配密切相关。专业开发者和普通用户都需要一款直观的内存...

基于Tkinter的PDF文件批量合并分割工具

PDF文档作为现代办公场景中的标准文件格式,其处理需求持续增长。针对文件合并与分割这两个高频操作,某开发者...

文件快捷导入工具(从表格恢复文件属性)

纸质文档电子化过程中,某工程设计公司曾陷入文件管理困境——两千余份竣工图纸的创建日期、版本编号、设计人...

多国货币实时汇率换算计算器

全球贸易与跨境消费的普及让汇率换算成为日常刚需。打开某款汇率计算器App,输入金额后界面瞬间跳转为美元、欧...

简易日历日程安排程序(事件提醒与重复设置)

日程管理已成为现代人生活刚需。一款功能简洁、操作便捷的日历工具能显著提升时间利用率,尤其在事件提醒与周...

带图表展示的CSV数据统计分析工具

在日常办公场景中,数据整理与分析占据着重要位置。CSV文件作为轻量级数据存储格式,因其兼容性强、操作便捷的...

局域网ARP欺骗检测与防护工具

局域网环境中,ARP协议作为网络通信的基础协议,其安全隐患往往容易被忽视。当某台主机的ARP缓存表被恶意篡改时...

图片圆形-心形特殊裁剪工具

刷朋友圈时总能看到各种形状的创意配图:宠物照片嵌在咖啡杯的热气里、情侣合影藏在心形图案中、圆形头像搭配...

利用PyGame的贪吃蛇小游戏开发工具

作为Python生态中最经典的2D游戏开发框架,PyGame自1999年诞生以来持续迭代,其直观的模块化设计至今仍是入门游戏开...

文件属性修改时间调整器

在日常办公或开发场景中,文件的时间戳信息(如创建时间、修改时间、访问时间)往往承载着重要价值。例如,程...

配置文件生成器(YAML-JSON互转)

在软件开发领域,YAML和JSON这对"双胞胎"格式正在引发技术人员的选择性困难。前者凭借人类可读性占据配置文件的半...

书籍磨损程度评级更新工具

书页泛黄、边缘磨损、装订开裂……这些细微变化决定了书籍的保存价值与修复优先级。传统人工评级依赖主观经验...

吊顶材料承重计算工具

吊顶材料承重计算工具作为现代建筑装饰领域的实用型辅助软件,近年来逐渐受到设计师、施工方及材料供应商的关...

自动化截图重复内容筛选删除器

数字时代,截图已成为记录信息的高频操作。工作文档、聊天记录、临时灵感……每一次点击保存的背后,是海量重...

多线程微博评论情感分析工具

海量信息爆炸的时代,微博平台每分钟新增数万条评论数据。传统人工筛选不仅耗时费力,单线程程序处理效率也难...

简易屏幕录像工具(带区域选择)

屏幕录制已成为现代人记录操作流程、分享创意内容的重要方式。在众多工具中, 简易屏幕录像工具 凭借"区域选择...

动态图表实时更新工具

在信息爆炸的时代,企业每天需要处理海量动态数据,而传统的静态图表已无法满足实时决策的需求。针对这一痛点...

算式练习生成器(自动批改小学生作业)

在教育信息化加速发展的背景下,一款名为"算术小帮手"的辅助工具正在小学教育领域引发关注。该工具通过集成算法...

文件编码格式转换工具(UTF-8-GBK转换)

打开电脑里的文档突然变成乱码,这种场景在数字办公时代并不少见。中文字符编码标准长期存在UTF-8与GBK两大阵营,...

简易画图板(保存为位图文件)

当灵感突然涌现时,快速捕捉创意往往比复杂的创作流程更重要。一款名为QuickSketch的绘图工具近期在设计圈引发关注...

批处理脚本整理工具(.bat)

日常办公中,文件整理常成为效率瓶颈。面对散落在各处的文档、图片或日志文件,多数人会选择手动归类,殊不知...