网页爬虫基础链接提取器

在互联网数据爆炸的今天,网页爬虫成为获取信息的重要工具。而链接提取器作为爬虫的核心组件之一,直接决定了数据采集的效率和精准度。本文将从实际应用出发,剖析链接提取器的核心逻辑,帮助开发者快速掌握其设计要点。

核心原理:从文本到结构化数据

链接提取器的本质是解析网页内容并定位超链接。传统方法依赖正则表达式匹配,通过模式识别筛选出符合规则的URL。例如,针对`

soup = BeautifulSoup(response.text, 'html.parser')

links = [a['href'] for a in soup.find_all('a', href=True)]

```

技术演进方向

随着页面复杂度的提升,未来的链接提取器可能融合语义分析技术。例如,通过识别页面中的上下文关联,自动过滤无关导航链接(如“返回首页”),直接锁定目标数据区块。结合机器学习模型预判链接有效性,可进一步减少无效请求的开销。

对于开发者而言,理解基础原理仍是应对复杂场景的关键。工具在进化,但底层逻辑始终围绕“精准定位”与“高效执行”展开。

- 上一篇:网页爬虫基础版(静态内容抓取)

- 下一篇:网页爬虫天气信息自动采集器

相关软件推荐

随机软件推荐

服务快捷方式创建管理器

系统桌面凌乱程度与工作效率往往成反比,当用户面对满屏的服务程序快捷方式时,高效管理工具的需求便应运而生...

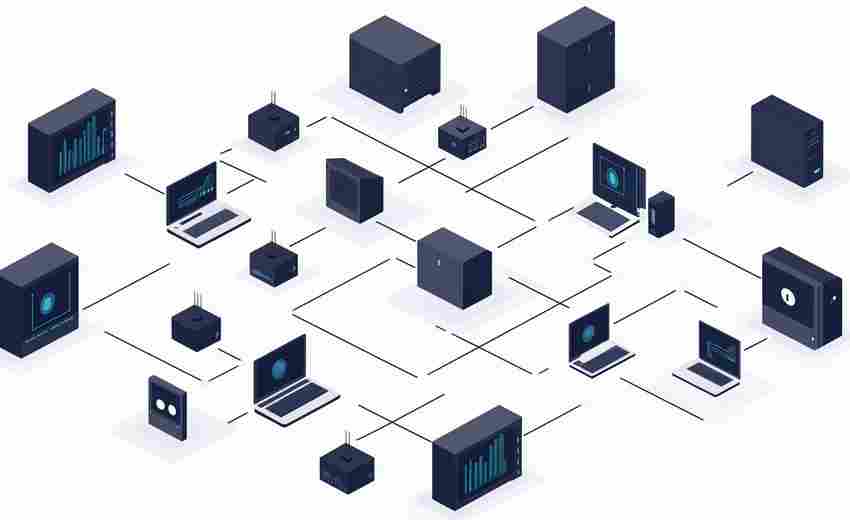

网络设备CPU-MEM监控工具

凌晨三点的机房警报声响起时,运维工程师最不愿看到的就是监控大屏上跳动的红色预警。某电商平台去年双十一的...

简易Flask博客内容管理工具

在个人博客搭建领域,开发者常面临功能冗余与维护成本的矛盾。一款基于Flask框架开发的内容管理工具正在技术社区...

键盘鼠标宏录制工具(记录并回放操作序列)

对于需要重复操作键盘鼠标的用户来说,手动执行成百上千次相同操作既耗费精力又容易出错。键盘鼠标宏录制工具...

串口通信协议自动识别工具

面对工业控制、物联网设备开发中复杂的串口通信场景,工程师常需耗费数周时间逆向解析未知协议格式。传统人工...

文件内容正则匹配替换工具

日常工作中,频繁面对海量文本文件的编辑需求时,手动逐行查找替换不仅耗时,还容易遗漏关键内容。一款基于正...

内存占用分析及清理助手

电脑运行速度突然变慢,任务栏频繁转圈,软件启动卡顿——这些症状往往源于内存资源过度占用。第三方内存分析...

简易实验数据3D散点图可视化工具

科研与工程领域的数据分析常面临多维数据可视化难题。传统二维图表难以展现变量间的复杂关系,而专业编程工具...

数学函数绘图工具(支持动态参数)

在数学教学和科研领域,可视化工具始终是理解抽象概念的重要桥梁。某款支持动态参数的函数绘图软件近期在工程...

家庭WiFi网络设备连接监控工具

深夜追剧卡顿的瞬间,路由器指示灯突然集体熄灭的清晨,游戏关键时刻的延迟飙升——这些场景背后往往藏着未知...

网页内容自动翻译工具

打开任意外文网页点击翻译按钮,十秒内即可阅读母语内容——这样的场景早已融入日常生活。网页自动翻译工具从...

基于关键词的代码文件智能分类器

在开发场景中,程序员常面临数百个代码文件混杂的困境。当项目规模超过5万行代码时,仅凭记忆定位特定功能模块...

简易网络爬虫数据采集工具(表格数据)

打开浏览器输入网址,肉眼逐行复制网页表格内容的日子早已过时。面对海量公开数据资源,一款名为TableCrawler的轻...

网络爬虫自动翻页抓取新闻聚合器

在信息爆炸的互联网环境中,新闻聚合平台需要持续获取时效性强、覆盖面广的内容资源。基于Python开发的SmartCrawl...

数据包载荷十六进制快速查看器

网络数据捕获后的解析工作常令工程师头疼。当Wireshark抓取到加密流量或非常见协议数据包时,传统分析工具常会显...

带版本控制的字体样式批量回滚工具

在数字设计领域,字体样式的迭代管理如同行走高空钢索——设计师面对数十个版本文件时,任何误操作都可能让两...

PDF转图邮件发送工具(自动附件发送)

清晨八点半的办公室键盘声此起彼伏,市场部李经理正盯着屏幕上刚完成的季度报告PDF文档。这份包含20张数据图表的...

汇率换算计算器(实时汇率语音查询)

跨国旅行时总遇到现金不够的尴尬,网购海外商品常因汇率波动多花冤枉钱,国际转账手续费明细永远算不清楚。汇...

动态生成二维码生成器

数字化浪潮下,二维码已成为连接物理世界与数字空间的。面对瞬息万变的市场需求,传统静态二维码逐渐暴露局限...

多项目并行任务分配管理器

企业日常运营中,经常出现这样的情况:某位技术骨干同时参与三个项目的代码开发,市场主管需要在同一天完成五...

专利引用关系可视化工具(NetworkX基础版)

在专利分析领域,可视化技术正成为研究者洞悉技术演进脉络的重要工具。基于Python的NetworkX库构建的专利引用关系可...

多标签待办事项清单管理工具

电脑屏幕右下角不断弹出的会议提醒,手机里堆积的未读工作群消息,随身笔记本上潦草记录的临时任务——现代职...

基于配置文件的自动化权限同步器

在数字化运维场景中,权限管理长期面临两大痛点:一是人工操作易出错,二是跨系统权限规则难统一。传统依赖脚...

文本文件关键词高亮搜索工具(支持多文件批量处理)

在日常办公或编程开发中,面对海量文本文件时,快速定位关键信息往往让人头疼。传统的文档搜索工具虽然能解决...

智能日程提醒桌面小部件

在信息过载的数字化时代,人们对于效率工具的依赖早已从"加分项"演变为"必需品"。当手机应用和电脑软件不断堆砌...

实验动物电子实验日志自动归档工具

实验室动物研究领域长期存在数据管理痛点。纸质记录易受环境因素干扰,笔误、涂改痕迹难以追溯,实验数据分散...

系统服务自动启停状态监控面板

清晨八点的机房,三台服务器突然陷入瘫痪。运维人员张工的手指在键盘上飞速移动,却始终无法定位故障根源——...

番茄工作法计时器(支持自定义时间段统计)

午后的办公室键盘声此起彼伏,设计师李然第八次点开社交软件后,发现原本计划三小时完成的设计稿只推进了10%。...

智能重复文件查找与清理工具(基于内容比对)

电脑屏幕右下角弹出存储空间不足的提示时,很多人才会惊觉文件管理早已失控。系统盘里躺着的三份不同命名的项...

重复文件查找与删除助手(MD5校验版)

随着电子设备存储容量扩大,用户积累的重复文件问题日益突出。手动排查不仅耗时,还可能遗漏内容相同但名称不...

使用Schedule库的定时任务提醒工具

日常工作中,常遇到需要定时执行任务的场景:比如准点发送日报、周期性备份数据,或是每隔一小时提醒自己喝水...

ReportLab PDF文档生成器

生成PDF文档是软件开发中的常见需求,尤其在需要精确控制版面的金融、医疗和教育领域。Python生态圈中,ReportLab工...

CSV与Excel表格双向转换合并工具

在数据处理领域,CSV与Excel格式的并存常带来操作困扰。CSV凭借轻量化与高兼容性成为数据存储的首选,Excel则以强大...

个人财务流水账目可视化分析系统

阳光透过办公室的百叶窗斜斜洒在电脑屏幕上,财务主管王明滑动鼠标滚轮,密密麻麻的收支数据在柱状图与饼状图...

BeeWare跨平台GUI工具包

在跨平台应用开发领域,开发者常常面临一个困境:如何在保持代码统一性的兼顾不同操作系统的原生体验?传统方...

简易截图工具(基于PIL图像处理)

在Python生态中,PIL(Python Imaging Library)及其分支Pillow库为图像处理提供了便捷的解决方案。基于该库实现的截图工具...

简易屏幕截图工具(区域-全屏)

日常办公或学习场景中,屏幕截图的使用频率远超想象。根据第三方数据平台统计,普通职场人日均截图操作超过8次...

多格式文件类型转换器(基于魔术字节验证)

在数字化办公场景中,文件格式转换需求呈几何级增长。某技术团队近期推出的FileMagic Converter工具,凭借魔术字节(...

简易俄罗斯方块游戏(键盘控制与积分系统)

当灰绿色像素块从屏幕顶端缓缓下坠时,三十年前风靡全球的经典游戏在当代编程工具中焕发新生。某开发者社区近...

邮件列表自动发送内容生成器

在信息爆炸的时代,邮件营销依然是企业与用户建立深度联系的核心渠道之一。但传统的手动邮件发送模式耗时耗力...